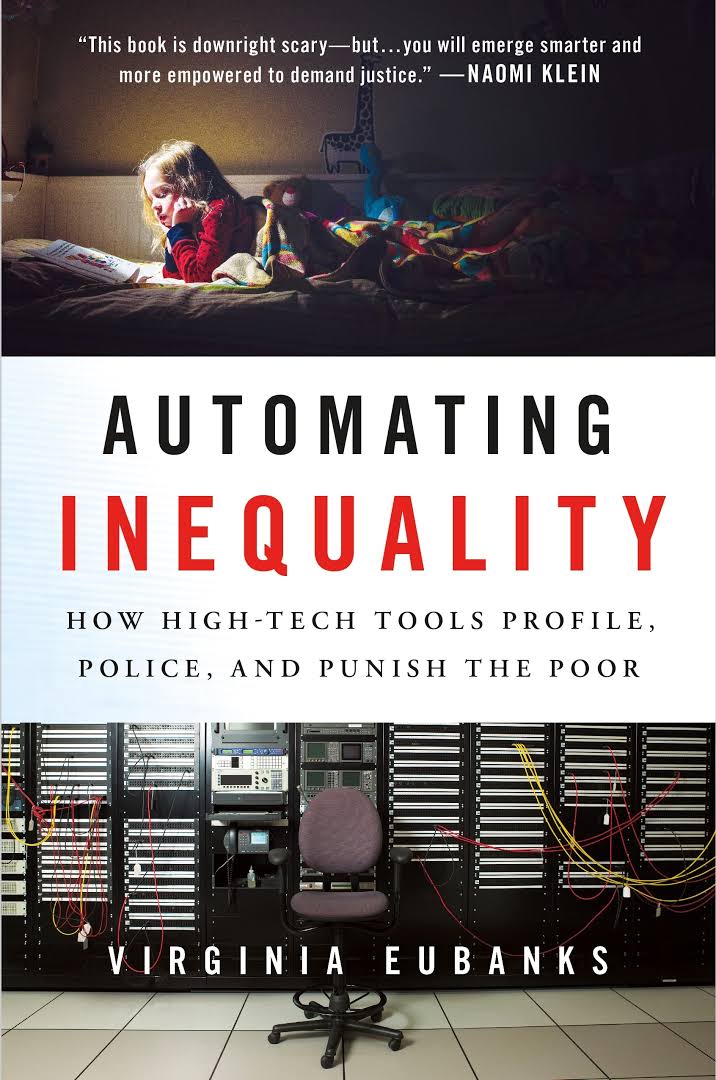

Eubanks, V. (2018). Automating Inequality. Picador, St Martin’s Press.

Recensão

Helena Carlo Gonçalo Ferreira [2025]

A Máquina da Desigualdade - Uma Recensão Crítica ao Livro Automating Inequality: How High-Tech Tools Profile, Police, and Punish the Poor de Virginia Eubanks

Na era do silício e dos algoritmos, onde a promessa digital parece ser a resposta para todos os males da sociedade, Virginia Eubanks emerge como uma voz dissonante e necessária na sua obra Automating Inequality: How High-Tech Tools Profile, Police, and Punish the Poor. Num momento em que Portugal abraça cada vez mais a digitalização dos serviços públicos e a implementação de sistemas automatizados de decisão, este livro surge como um alerta vermelho que não podemos ignorar. Por isso, esta recensão não pretende ser convencional, bem pelo contrário, o objetivo é mergulhar na obra como quem desconstrói um edifício digital assente em terrenos minados pela injustiça histórica.

Virginia Eubanks apresenta-nos uma investigação profunda e perturbadora sobre como os sistemas automatizados de decisão, longe de serem as ferramentas neutras e objetivas que nos vendem, estão a recriar e amplificar as desigualdades sociais existentes. Num mundo que venera algoritmos como deuses matemáticos e imparciais, o livro revela que os sistemas automatizados são tudo menos objetivos. Estão embebidos nos preconceitos humanos de quem os concebe e programados para perpetuar as desigualdades de classe, raça e género. É como se tivéssemos pegado nos preconceitos e discriminações da sociedade e os tivéssemos codificado em linguagem binária, criando o que a autora apropriadamente denomina de "digital poorhouse" - uma versão high-tech das antigas workhouses vitorianas (1).

Quando transportamos a narrativa de Virginia Eubanks para o contexto português, atribuímos-lhe uma relevância própria, uma vez que no nosso país assistimos a uma rápida digitalização dos serviços públicos sob a égide do Plano de Recuperação e Resiliência (PRR) (2) e da Estratégia para a Transformação Digital da Administração Pública 2021-2026 (3). Por um lado, celebramos iniciativas como o ePortugal (4) e a proliferação de smart cities de norte a sul do país. Por outro, raramente questionamos o impacto desta transformação digital nas populações mais vulneráveis.

Exemplificamos com casos concretos: o processo de marcação de consultas no SNS digital, que pressupõe não só acesso à internet mas também literacia digital; o sistema automatizado de atribuição de vagas escolares, que pode perpetuar desigualdades territoriais; ou ainda os algoritmos de avaliação de risco de crédito que, sob a aparência de objetividade, podem reforçar padrões históricos de exclusão financeira. Em Portugal, onde cerca de 25% da população ainda apresenta baixos níveis de literacia digital e onde existem assimetrias significativas no acesso à internet entre zonas urbanas e rurais (5), estas questões ganham uma importância particular.

A autora confronta-nos com estas realidades através de três estudos de caso nos Estados Unidos, mas as suas implicações são profundamente pertinentes para Portugal, especialmente quando o país se prepara para investir milhões de euros na modernização digital da administração pública. Este investimento massivo em tecnologia levanta questões cruciais sobre equidade e acesso, particularmente num país onde as desigualdades sociais são já significativas - recordemos que Portugal continua a ser um dos países da União Europeia com maior índice de desigualdade na distribuição de rendimentos (6).

O primeiro caso, por exemplo, passado em Indiana, revela como a automatização dos serviços sociais levou a um sistema kafkiano onde os mais necessitados se veem enredados numa teia burocrática digital impossível de navegar. Um sistema de triagem automatizado promete “eficiência” na gestão da assistência social. Aqui, “eficiência” é uma palavra-código para exclusão, onde algoritmos decidem, sem recurso ao humano, quem merece ajuda e quem deve ser descartado. A “neutralidade” do sistema não é senão uma miragem, as decisões são moldadas por dados históricos profundamente enviesados, que perpetuam ciclos de pobreza e exclusão. Não é difícil estabelecer um paralelo com a crescente digitalização dos serviços públicos em Portugal, onde idosos e pessoas com menor literacia digital se veem cada vez mais marginalizados e excluídos do acesso a serviços essenciais. E, logo neste primeiro exemplo fica provado que as tecnologias não eliminam preconceitos, amplificam-nos.

O segundo caso, em Los Angeles, expõe como um sistema automatizado de atribuição de habitação social acabou por perpetuar a ausência de um teto às pessoas em situação de sem-abrigo em vez de os resolver. Aqui, algoritmos determinam quem terá acesso a habitação de emergência, baseando-se em modelos de risco que, frequentemente, penalizam aqueles que já se encontram nas margens mais extremas da sociedade. A lógica subjacente a estes sistemas é profundamente darwinista: só os mais “dignos” sobrevivem. Mas, o que é a “dignidade”? E mais, quem decide o que significa? O sistema opera com base em métricas desumanizadoras, transformando pessoas em números e vulnerabilidades em falhas de caráter. Há aqui ecos da lógica colonialista, onde os corpos das pessoas marginalizadas são alvo de vigilância e controlo, enquanto os privilégios dos mais poderosos permanecem intocados.

Esta análise ganha contornos pertinentes quando observamos a atual crise habitacional em Portugal. Com a crescente digitalização dos processos de candidatura a habitação pública, começamos a ver a emergência de sistemas automatizados de pontuação e classificação de candidatos que, à semelhança do caso americano, podem inadvertidamente amplificar desigualdades existentes. Consideremos, por exemplo, os sistemas municipais de gestão de habitação social, como é o caso da plataforma Habitar Lisboa (7) onde algoritmos começam a ser utilizados para processar candidaturas e atribuir pontuações. Estes sistemas, aparentemente neutros, podem perpetuar exclusões históricas: famílias sem acesso digital regular têm dificuldade em manter as suas candidaturas atualizadas; critérios automatizados de pontuação podem penalizar situações de precariedade laboral ou irregularidade de rendimentos, comuns entre os mais vulneráveis; e a própria exigência de documentação digital pode criar barreiras invisíveis para pessoas em situação de sem-abrigo ou habitação precária.

Em cidades como Lisboa e Porto, onde a pressão habitacional é particularmente aguda, estes sistemas automatizados interagem com outros fatores de exclusão: a gentrificação acelerada, a explosão do alojamento local, e a financeirização do mercado imobiliário. Quando os algoritmos de atribuição de habitação social não consideram adequadamente estas dinâmicas urbanas complexas, podem acabar por empurrar as populações mais vulneráveis para as periferias cada vez mais distantes, criando novos padrões de segregação espacial.

O terceiro caso, focado em Pittsburgh, demonstra como os sistemas de previsão de risco na proteção de menores podem perpetuar preconceitos raciais e socioeconómicos. Esta análise ressoa profundamente em Portugal, onde a crescente digitalização dos serviços da Comissão de Proteção de Crianças e Jovens (CPCJ) e da Segurança Social introduz novos desafios na forma como identificamos e gerimos situações de risco.

O contexto português apresenta particularidades importantes: temos comunidades historicamente marginalizadas - desde bairros sociais nas periferias urbanas até comunidades ciganas e imigrantes - que já enfrentam um escrutínio desproporcional dos serviços sociais. A introdução de sistemas automatizados de avaliação de risco pode amplificar estes vieses existentes. Por exemplo, quando algoritmos consideram fatores como "estabilidade habitacional" ou "situação profissional", podem penalizar desproporcionalmente famílias em situação de precariedade laboral ou habitacional, comuns em comunidades já vulnerabilizadas.

O Sistema de Informação e Monitorização do Sistema de Promoção e Proteção (SIM-CPCJ) (8), embora tenha modernizado a gestão de processos, levanta questões importantes sobre como os dados são coletados e interpretados. Quando indicadores aparentemente objetivos como "assiduidade escolar", "condições habitacionais" ou "rendimento familiar" são processados algoritmicamente, podem mascarar realidades sociais complexas. Uma família que vive num bairro estigmatizado, ou uma criança que falta à escola para ajudar em casa devido à precariedade económica dos pais, podem ser automaticamente sinalizadas como "alto risco" sem considerar o contexto social mais amplo.

Particularmente preocupante é como estes sistemas podem reforçar o racismo institucional, onde práticas discriminatórias são perpetuadas através de processos aparentemente neutros e tecnocráticos. Em Portugal, onde o discurso oficial frequentemente nega a existência de discriminação racial e étnica sob o manto do “luso-tropicalismo” e da suposta harmonia multicultural, sistemas automatizados podem dar uma aparência de objetividade a decisões que, na realidade, reproduzem padrões históricos de exclusão.

Virginia Eubanks desarma metodicamente o mito da neutralidade tecnológica e demonstra, de modo claro, como estes sistemas são, na verdade, escolhas políticas codificadas em software. Não são "apenas matemática" ou "apenas código", são manifestações digitais de valores sociais, preconceitos e decisões políticas. A obra é particularmente brilhante quando explora o conceito de "high-tech containment of the poor” (9). Virginia Eubanks argumenta que, longe de resolver problemas sociais, muitos destes sistemas servem apenas para tornar a pobreza mais eficientemente gerível - uma observação que deveria fazer soar todos os nossos alarmes, principalmente numa altura em que Portugal (e o resto do mundo) abraça cada vez mais soluções tecnológicas para problemas sociais complexos.

Um dos aspetos mais provocadores do livro é a forma como a autora desconstrói a narrativa de "fracasso do sistema". Quando estes sistemas automatizados produzem resultados discriminatórios ou injustos, a tendência é considerá-los como falhas técnicas que podem ser corrigidas com mais dados ou melhores algoritmos. No entanto, a autora argumenta convincentemente que estes não são bugs (10), mas features (11), ou seja, os sistemas estão a funcionar exatamente como foram desenhados para funcionar, refletindo e amplificando as desigualdades existentes na sociedade.

A autora pode parecer excessivamente pessimista em relação ao potencial da tecnologia para resolver problemas sociais. No entanto, este aparente pessimismo pode ser visto como o necessário contraponto ao tecno-otimismo acrítico que domina grande parte do discurso público sobre inovação digital. Para o leitor português, esta obra oferece uma oportunidade única de reflexão num momento crucial. Enquanto o país se move rapidamente em direção a uma maior digitalização dos serviços públicos e adoção de sistemas automatizados de decisão, o livro serve como um poderoso aviso de que a tecnologia não é neutra e que as escolhas que fazemos hoje sobre como implementar estes sistemas terão consequências profundas para a justiça social nas próximas décadas. A autora obriga-nos a questionar não apenas se é possível automatizar certos processos de decisão social, mas se devemos e queremos fazê-lo e num momento em que Portugal se prepara para receber fundos significativos para a transição digital, esta é uma questão que merece ser debatida com urgência e profundidade.

Automating Inequality: How High-Tech Tools Profile, Police, and Punish the Poor é, em última análise, um grito de alerta contra o que a autora chama de determinismo digital, ou seja, a ideia de que a tecnologia é inevitável e que o progresso tecnológico é sempre positivo. É um livro que nos obriga a confrontar as consequências éticas e sociais das nossas escolhas tecnológicas e a reconhecer que a automação, quando aplicada sem crítica aos sistemas sociais, pode servir mais para perpetuar do que para resolver as desigualdades existentes. A autora dedica, por isso, especial atenção às resistências que emergem em oposição a estes construtos de desigualdade e revela o quanto comunidades, ativistas e académicos se uniram para desmantelar os sistemas de opressão automatizada, insistindo na centralidade da humanidade num mundo dominado por máquinas. No entanto, uma questão se levanta: como se luta contra um inimigo invisível? Os sistemas automatizados operam numa esfera opaca, onde os algoritmos são protegidos por muros de “propriedade intelectual” e burocracias corporativas. Desafiar estas máquinas exige não apenas competência técnica, mas também uma nova ética coletiva, onde a dignidade humana seja colocada no centro de todas as decisões tecnológicas.

Virginia Eubanks não oferece soluções fáceis – e ainda bem. A força de Automating Inequality… reside no seu convite ao desassossego, obrigando-nos a encarar as contradições do nosso tempo. A obra faz perguntas fundamentais: estamos a criar um futuro onde a tecnologia amplifica as nossas melhores qualidades humanas ou os nossos piores preconceitos? E, é aqui que deixo a minha maior crítica à obra: enquanto leitura necessária e profundamente informada, o livro deixa uma lacuna ao não abordar em profundidade as possibilidades de imaginar sistemas alternativos. Embora o seu foco seja a denúncia das injustiças, seria enriquecedor explorar mais exemplos de tecnologias usadas para emancipação e não para opressão, porque a questão que me ficou é: está a automação condenada a ser uma ferramenta de exclusão ou poderá, com outro design, servir como alicerce de uma sociedade mais justa?

Se há algo que Virginia Eubanks deixa claro, é que o futuro tecnológico não é decidido pelas máquinas, mas pelas pessoas e este é um apelo urgente a todos nós: programadores, académicos, ativistas e cidadãos comuns. Precisamos de reimaginar o que significa viver numa sociedade digital e construir ferramentas que ampliem a dignidade humana em vez de a corroerem. Em última análise, Automating Inequality… é mais do que um livro, é uma convocação à resistência e uma lembrança de que, por trás de cada algoritmo, existe uma escolha humana.

O futuro está em jogo e a decisão é só nossa, por isso: Humanos de todo o mundo, uni-vos!

Notas:

(1). Instituições onde os pobres da Inglaterra vitoriana eram forçados a trabalhar em condições desumanas em troca de sustento básico, num sistema deliberadamente cruel para desencorajar pedidos de ajuda.

(2). https://eurocid.mne.gov.pt/artigos/plano-de-recuperacao-e-resiliencia

(3). https://digital.gov.pt/estrategias/estrategia-2021-2026

(4). https://www.gov.pt/

(5). https://www.anacom-consumidor.pt/documents/20181/29099323/CompetenciasDigitais2023/e698ffce-2115-46d0-903b-3b859bda2bd2

(6). https://ffms.pt/pt-pt/estudos/estudos/portugal-desigual-um-retrato-das-desigualdades-de-rendimentos-e-da-pobreza-no-pais

(7). https://habitarlisboa.cm-lisboa.pt/ords/f?p=100:2::::::

(8). https://cpcj.cnpcjr.pt/cpcj/index.faces

(9). Que traduziria para "confinamento tecnológico da pobreza", porque “confinamento" captura melhor a ideia de contenção forçada.

(10). Defeitos – erros de software.

(11). Caraterísticas pretendidas – elementos intencionais do sistema.

Última atualização em 23 de fevereiro de 2026